ふとバーチャルYoutuberのアプリを作りたくなったのでリソースを探すけど,詳しい説明が無かったのでメモ

必用なもの

iPhoneX以降,Unity2018.2以降,XCODE

Unity Packageを以下からダウンロードしインストール

https://github.com/Unity-Technologies/facial-ar-remote/releases

新規Unityプロジェクトを立ち上げる

【ビルドの設定】

- UnityをiOSビルドに変更

- faical-ar-remote>Remote>Scene>Clientを起動

- File>Build Settings>Player Settingsを起動

- other settingsのBundle Identifierを設定

- Target minimum iOS version を11.3以上にする

- Camera Usage Description に AR Face Tracking と入力

- Requires ARKit にチェックを入れる

- Scripting Define Symbols に ARKIT_1_5 と入力

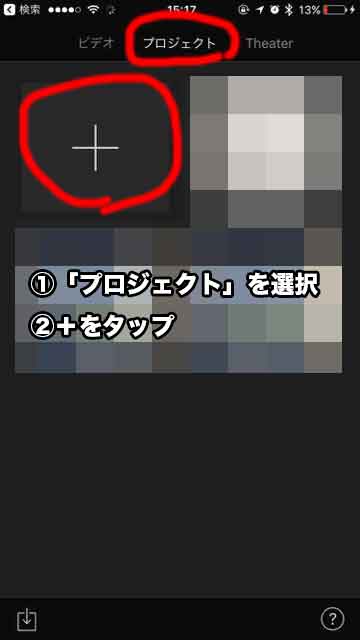

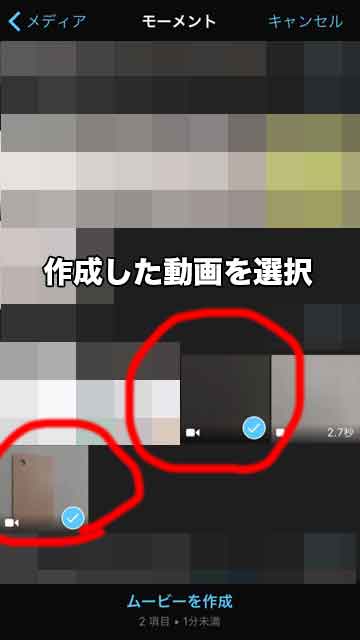

【まずiPhoneアプリを作成】

- final-ar-remote>Remote>Scene>Clientを開いているか確認

- ビルドし,XCODEでアプリ化しデバイスにインストール

- 作成されたアプリを起動

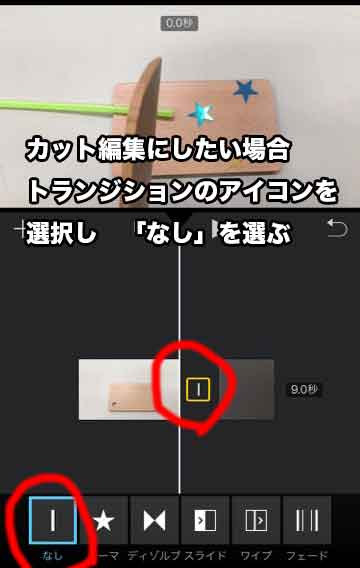

【サンプルシーンを開いて確認】

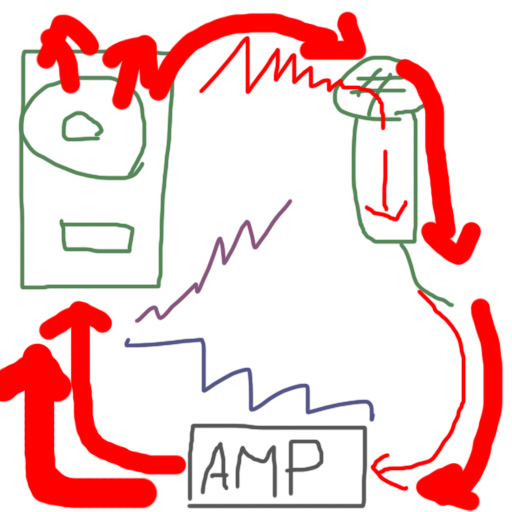

- iPhoneとMacが同じルータ内に接続されているか確認

- final-ar-remote>Examples>Scenes>SlothBlendShapesを開く

- SlothBlendShapesのHierarchyのStreamReaderのInspectorのNetworkStreamのPortをiphoneアプリにポートと同じにする

- 再生ボタンをクリック

- ConsoleにIPアドレスが出る(2つIPアドレスが出る時はWifiと有線LANが見えているのでどちらか切るといいかも)

- iPhoneのアプリにConsoleに表示されたIPアドレスを入力

- iPhoneのアプリでConnectを押す

facialが動きます.お疲れ様でした.

参考サイト

https://github.com/Unity-Technologies/facial-ar-remote

https://blogs.unity3d.com/jp/2018/08/13/facial-ar-remote-animating-with-ar/

https://qiita.com/Yuzu_Unity/items/91fc2b6f8ebe0fc0e839

https://qiita.com/syoyo/items/f0ad3eb4ed3387ee6462